Nakon godine u kojoj je generativna umjetna inteligencija istodobno bila i svemoćna, ali nas i s vremena na vrijeme zamarala, 2026. bi mogla označiti ozbiljan zaokret. Dok su chatbotovi i dalje u fokusu, sve je više znakova da industrija traži alternative – tehnološke, ekonomske i društvene

Kada su svjetske izdavačke kuće i rječnici birale riječi godine, među njima se našao i 'AI slop', izraz za goleme količine sadržaja na internetu sumnjive kvalitete koje proizvodi umjetna inteligencija. Istodobno su se pojačale rasprave o pucanju AI balona, održivosti ulaganja i granicama trenutačnih modela.

No to nije zaustavilo tehnološke divove. Novi model Gemini 3 iz tvrtke Google uzdrmao je tržište, a u industriji se šuškalo da je u OpenAI proglašen interni 'code red' kako bi se ubrzao razvoj modela GPT-5. No kako i sami čelnici AI sektora upozoravaju da smo dosegli tzv. 'peak data' – granicu dostupnih, kvalitetnih podataka za treniranje – pitanje je što slijedi dalje, piše Euronews.

Uspon 'svjetskih modela'

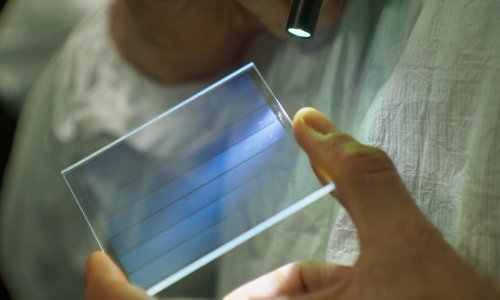

Problem 'peak data' ne znači da podataka nema. Naprotiv, ogromne količine informacija ostaju neiskorištene zbog regulatornih ograničenja, autorskih prava ili tehničke nepristupačnosti. Upravo tu na scenu stupaju tzv. svjetski modeli.

Za razliku od velikih jezičnih modela koji predviđaju sljedeću riječ, svjetski modeli pokušavaju predvidjeti što će se dogoditi u sljedećem trenutku u stvarnom vremenu u svijetu – kako se objekti kreću, sudaraju i utječu jedni na druge kroz vrijeme. Uče promatrajući videozapise, simulacije i prostorne podatke, gradeći vlastite reprezentacije objekata, kretanja i uzročno-posljedičnih odnosa.

Pojednostavljeno: umjesto da 'razgovaraju', oni razumiju fiziku, prostor i vrijeme. Zato ih se često opisuje i kao digitalne blizance, virtualne replike stvarnih prostora ili sustava u kojima se mogu simulirati budući scenariji.

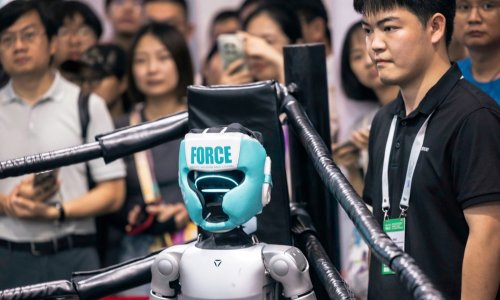

Takav pristup mogao bi biti ključan za razvoj robotike, autonomnih sustava i videoigara. Direktor tvrtke Boston Dynamics Robert Playter rekao je za Euronews Next da umjetna inteligencija već sada ima presudnu ulogu u razvoju njihovih robota, uključujući poznatog robotskog psa.

Interes industrije je očit: vlastite verzije svjetskih modela najavili su i Meta i Google, dok je jedan od 'kumova' umjetne inteligencije, Yann LeCun, 2025. objavio da napušta Metu kako bi pokrenuo startup posvećen upravo toj tehnologiji. Slično razmišlja i Fei-Fei Li, čija je tvrtka World Labs predstavila prvi model Marble. U utrku su se uključile i kineske kompanije poput Tencenta.

Europski put: Manji modeli umjesto velikih sustava

Dok se globalna AI scena utrkuje u veličini i snazi modela, Europa bi mogla krenuti suprotnim smjerom. Umjesto megamodela, sve više pažnje dobivaju mali jezični modeli.

Riječ je o 'jednostavnijim' verzijama velikih sustava, dizajniranim za rad na pametnim telefonima ili slabijim računalima. Iako koriste manje parametara i troše znatno manje energije, zadržavaju solidne sposobnosti – od generiranja teksta i sažimanja do prevođenja i odgovaranja na pitanja.

U kontekstu sve glasnijih upozorenja o AI balonu, takvi modeli djeluju i ekonomski razumnije. Američke AI tvrtke trenutačno ulažu goleme svote u izgradnju podatkovnih centara, što podiže pitanje dugoročne isplativosti.

'Sumnje u financijsku održivost i stvarne društvene koristi današnjeg AI booma nastavit će rasti, čak i ako balon ne pukne', upozorio je Max von Thun iz Open Markets Institutea. Dodao je i da bi europske vlade mogle postati opreznije prema oslanjanju na američku AI i cloud infrastrukturu, osobito zbog geopolitičkih pritisaka.

Rezultat bi mogao biti ubrzan razvoj lokalnih kapaciteta i fokus na održivije, specijalizirane modele trenirane na kvalitetnim industrijskim i javnim podacima, području u kojem Europa ima realne prednosti.

Snažniji modeli, veći rizici

Iza tehničkog napretka ostaju ozbiljna etička pitanja. Godinu 2025. obilježile su i zabrinjavajuće rasprave o tzv. 'AI psihozi', situacijama u kojima korisnici razvijaju opsesivne odnose s chatbotovima. Posebnu je pozornost privukla tužba protiv OpenAI-ja u kojoj se tvrdilo da je ChatGPT poticao maloljetnika na samoubojstvo, što je tvrtka odlučno odbacila.

Takvi slučajevi otvaraju pitanje odgovornosti tehnoloških kompanija, osobito kako modeli postaju sve moćniji. Prema riječima Maxa Tegmarka, profesora s MIT-a i predsjednika organizacije Future of Life Institute, inženjeri često nisu ni svjesni štetnih posljedica koje njihovi sustavi mogu imati na ranjive korisnike.

Tegmark očekuje da će 2026. donijeti još snažnije AI sustave, ali i razvoj tzv. AI agenata – autonomnih programa koji mogu samostalno djelovati u ime korisnika, bez stalne ljudske kontrole. Iako su danas još ograničeni, potencijal takvih sustava otvara i nova sigurnosna pitanja.

Sukob oko neregulirane umjetne inteligencije

Uz tehnološke i ekonomske dileme, 2026. bi mogla donijeti i otvoren društveni sukob oko regulacije AI-ja. U SAD-u je regulacija oslabila nakon što je predsjednik Donald Trump potpisao izvršnu uredbu kojom se saveznim državama otežava donošenje vlastitih AI pravila, uz obrazloženje da bi to oslabilo američku poziciju u globalnoj utrci, osobito prema Kini.

Istodobno, tisuće javnih osoba – od tehnoloških stručnjaka do političara i vjerskih vođa – potpisale su peticiju kojom pozivaju na usporavanje razvoja tzv. superinteligencije. Tegmark upozorava da dio javnosti strahuje kako bi takva tehnologija mogla 'učiniti ljudski rad besmislenim', no dodaje i da bi potpuni izostanak regulacije mogao izazvati snažan 'tech-lash', društveni otpor koji bi zakočio i korisne primjene AI-ja, primjerice u zdravstvu.

'Ako nema pravila, riskiramo da gubitak dobrobiti umjetne inteligencije zajedno s onim lošim značajkama', zaključuje Tegmark.