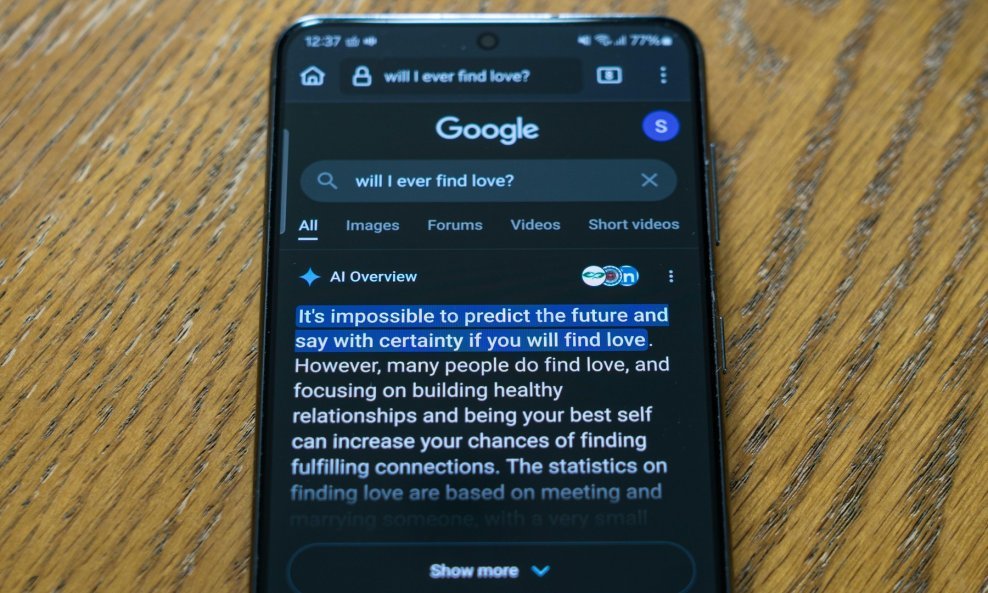

Umjesto usmjeravanja korisnika izravno na web stranice, sažima informacije iz rezultata pretraživanja i predstavlja vlastiti odgovor generiran umjetnom inteligencijom zajedno s nekoliko poveznica

Googleova značajka AI Overviews, osmišljena za davanje brzih odgovora na upite za pretraživanje, navodno izbacuje halucinacije češće nego što su u toj tvrtci spremni priznati. Također potkopava izdavače odvlačeći korisnike od tradicionalnih poveznica.

Veliki tehnološki div - koji je prošle godine dospio u nevolje nakon što je objavio alat s umjetnom inteligencijom koji je generirao slike ženskih papa i crnih Vikinga - kritiziran je zbog pružanja lažnih, a ponekad i opasnih savjeta u svojim sažecima.

U jednom slučaju, AI Overviews savjetovao je dodavanje ljepila u umak za pizzu kako bi se sir bolje zalijepio. U drugom slučaju, opisao je lažnu frazu Ne možeš dvaput polizati jazavca kao legitimni idiom. Situaciju pogoršava to što Googleov alat smanjuje vidljivost vjerodostojnih izvora.

Umjesto usmjeravanja korisnika izravno na web stranice, sažima informacije iz rezultata pretraživanja i predstavlja vlastiti odgovor generiran umjetnom inteligencijom zajedno s nekoliko poveznica.

Prema istraživanju analitičke tvrtke Authoritas, stope klikanja na web stranice izdavača padaju za 40 do 60 posto kada se prikazuju AI Overviews.

Umanjivanje i samoobrana

Ta je značajka predstavljena prošlog ljeta. Pokreće ih Googleov veliki jezični model Gemini. Unatoč zabrinutosti javnosti, glavni izvršni direktor Googlea Sundar Pichai branio je alat, navodeći kako pomaže korisnicima u otkrivanju šireg raspona izvora informacija i šalje promet širem rasponu izvora i izdavača.

Čini se kako Google umanjuje vlastitu stopu halucinacija. Na upit o tome koliko često njegova umjetna inteligencija griješi, odgovor umjetne inteligencije bio je kako su stope halucinacija između 0,7 i 1,3 posto.

Međutim, podaci s platforme za praćenje umjetne inteligencije Hugging Face pokazali kako da je stvarna stopa za najnoviji model Geminija 1,8 posto. Čini se kako Googleovi modeli umjetne inteligencije također nude unaprijed programirane obrane vlastitog ponašanja. Kao odgovor na pitanje krade li umjetna inteligencija umjetnička djela, alat je rekao kako ne krade u tradicionalnom smislu.

Na pitanje trebaju li se ljudi bojati umjetne inteligencije, alat je prošao kroz neke uobičajene prigovore prije nego što je zaključio kako je 'strah možda pretjeran'. Neki stručnjaci upozoravaju kako generativni sustavi umjetne inteligencije postaju skloniji pogreškama kako raste njihova složenost. Ni njihovi tvorci ne mogu u potpunosti objasniti zašto.

Slično se događa i s novim modelima OpenAI-ja, piše New York Post.